模擬對話丨實現更智能的數字預失真引擎:一種基于神經網絡的方法

在基于神經網絡的數字預失真(DPD)模型中,使用不同的激活函數對整個系統性能和能效有何影響?

像整流線性單元(ReLU)這類計算高效的激活函數能夠降低能耗,因此更適合移動設備和物聯網設備等資源受限的環境。相反,諸如 sigmoid 和 tanh 等更復雜的函數,盡管在某些場景下能帶來更優的性能,但由于計算需求更高,可能會增加能耗。因此,在數字預失真(DPD)模型中選擇激活函數時,需同時兼顧性能和能效,以根據目標應用優化系統。

為了解決下一代無線通信中功率放大器(PA)的信號失真和效率低下的難題,本文提出了一種AI驅動的數字預失真(DPD)框架。基于多項式的傳統DPD方法存在計算復雜性問題,而且對非線性和記憶效應的適應能力有限。本文提出的系統利用了先進的神經網絡架構動態優化預失真,在效率、適應性和實時校正等方面均優于傳統方法。盡管存在模型可解釋性和能耗等挑戰,基于此框架打造的可擴展、高效率的解決方案依然代表了現代通信網絡射頻發射器設計的一項重大進步。

OpenAI于2022年11月推出的ChatGPT,是史上用戶增長速度最快的軟件產品之一,充分展現了人工智能(AI)的巨大潛力。機器學習(ML)是AI的一個分支,能夠促進計算機執行決策和數據分析等任務,深刻改變了各行各業。在通信領域,數字預失真(DPD)技術在AI和ML的推動下不斷發展,這項技術對于減少信號失真和提升功率放大器(PA)的效率至關重要。傳統DPD模型難以處理5G等現代通信系統中存在的非線性特性和記憶效應。這些傳統模型假定PA的行為是靜態且無記憶的,因此僅通過多項式來描述輸入輸出之間的瞬時關系。然而,AI和ML擅長學習復雜模式,因此能夠給出更精確的解決方案。本文提出了一種基于人工神經網絡的DPD框架,利用PA數據來降低增益/相位誤差、提升效率并改善頻譜性能,其效果優于傳統方法。

數字預失真是一項關鍵技術,它使功率放大器能夠在飽和區附近高效工作,同時不損害線性度。DPD通過擴展PA的線性工作范圍,讓射頻(RF)設計人員能夠充分利用非線性PA的效率優勢,同時保持發射信號的線性度,滿足正交頻分復用(OFDM)等復雜調制方案的需求。

DPD的基本原理是預失真系數的引入。預失真系數是基于對PA的逆向幅度到幅度(AM-to-AM)和幅度到相位(AM-to-PM)的特性進行建模而得出的。在此過程中,精確的反失真被引入輸入波形中,從而有效補償PA的非線性。因此,DPD不僅能改善信號質量,而且讓PA能夠以峰值效率工作。關于DPD算法及ADI公司的 ADRV9040 RF 收發器如何為DPD的設計和實現提供精簡硬件平臺的詳細內容,請參閱“簡化5G基站發射器配置、設計和評估” 一文。圖1展示了利用DPD使PA響應線性化的原理。

圖1. 利用DPD使PA響應線性化的原理:(a)整體線性區域的典型AM到AM曲線(綠色);(b)DPD的基本概念以及它如何提升功率放大器的效率。

功率放大器在接近飽和時會表現出非線性,從而導致信號失真、頻譜再生和效率降低,這在具有I/Q不平衡和記憶效應等缺陷的高帶寬系統中尤其顯著。AI和ML,尤其是神經網絡(NN),能夠對PA失真進行建模并動態優化預失真,從而帶來顛覆性的改進。這種AI驅動的方法提升了系統的效率和適應性,優于傳統方法,同時在性能和計算復雜性之間取得了平衡。

人工神經網絡是人工智能的基石,尤其是在深度學習領域。神經網絡的設計初衷是為了克服傳統機器學習算法的局限性。受人類大腦處理信息能力的啟發,神經網絡擅長模式識別、學習和決策,因此非常適合解決復雜的非線性問題。例如,在5G LTE系統中,利用基于神經網絡的DPD方法可以有效解決I/Q不平衡、相移、DC偏移、串擾和PA非線性等難題。

基于多項式的DPD方案依賴于對系統機制的深入理解,且難以擴展;相比之下,神經網絡模型擅長以較少的約束條件處理復雜的非線性行為。本節文章提出一種NN DPD框架,以減輕非線性和發射器缺陷的影響。過程中涉及三個關鍵步驟:測試PA特性并收集大量數據、訓練后失真神經網絡模型、部署模型并進行性能監控和調整。此方法通過機器學習將大型數據集轉化為可實踐的操作,從而為應對現代通信挑戰提供穩健、可擴展的解決方案。

第1步:收集PA特性數據

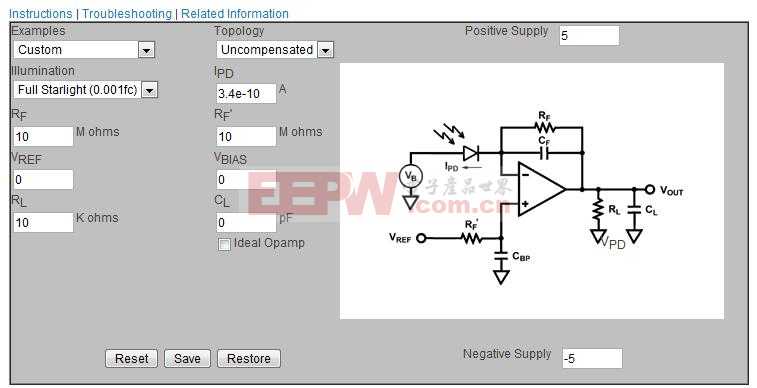

為了設計和實現用于優化無線功率放大器的AI/ML模型,收集全面、高質量的特性數據至關重要,這些數據應當準確反映PA在不同條件下的實際性能。圖2顯示了一種可用于PA特性數據收集的示例配置。

圖2. 用于寬帶PA特性分析的測量配置。

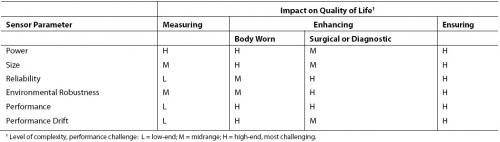

通過圖2所示的測試平臺可以全面分析器件特性,提取S參數、輸出功率、功率附加效率(PAE)、輸入阻抗、輸入回波損耗、功率增益、AM到PM轉換等其他參數。表1詳細列出了模型所需的所有輸入數據。但需要注意的是,模型的維數會影響其響應時間。此外,采集的數據必須先數字化,然后才能用于訓練過程。

表1. 測量項目及其描述

這種嚴格而系統的數據收集方法為開發能夠準確預測和優化PA性能的AI/ML模型奠定了基礎。借助這種全面的數據集,設計人員可以實現可靠、高效的無線通信系統。

第2步:訓練模型

模型訓練過程包括將表1中收集的(部分或全部)信號輸入到系統中,并通過損失函數來優化DPD模型以使誤差最小化。神經網絡架構由相互連接的節點層(例如人工神經元)組成,即圖3所示的組成部分。

圖3. 深度學習中的多類別預測神經網絡架構。

表2. 神經網絡核心組成部分和描述

在訓練期間,隱藏層使數據前向傳播,而權重和偏置通過反向傳播和梯度下降算法進行優化。神經網絡結構可進行調整,以包含更多神經元(適用于高度非線性的分量)或更少神經元(適用于較平滑的元素)。

關于哪些AI硬件、軟件和工具最適合用來創建高效、可擴展的AI模型訓練環境,本文不作深入探討,但我們建議AI工程師可以嘗試一下KNIME,這是一個用于數據分析和機器學習的無代碼平臺。KNIME具有圖形用戶界面(GUI),用戶只需拖放節點即可設計工作流程,無需掌握大量編程知識。所設計的工作流程非常直觀且易于理解,因此適合廣大用戶使用。對于更傾向于使用Python進行開發的人來說,Keras與TensorFlow?的結合能帶來顯著優勢,將Keras的簡單易用性與TensorFlow的穩健性和可擴展性相融合,是實驗級或生產級深度學習應用等各類項目的理想選擇。

PA特性分析工作涉及到百萬級樣本的收集,其中70%用于訓練,30%用于測試和驗證,以評估模型模擬PA行為的能力。模型性能通過準確率、精度、召回率、F1分數和ROC-AUC等指標來評估。

第3步:驗證和部署神經網絡模型

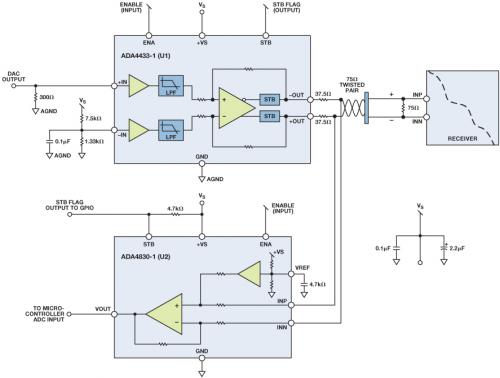

部署過程從模型的驗證開始,以確保模型的穩健性和準確性。驗證集用于監控訓練質量并決定何時停止訓練,測試集則用于獨立評估模型的準確性和泛化能力。解決過擬合和欠擬合問題,對于確保模型在新數據集上的表現至關重要。為抑制過擬合、提升模型的泛化能力,可采用以下方法:精簡模型架構,限制神經網絡層數、隱藏神經元數量或參數規模;擴充訓練數據集規模;或實施裁剪,例如剔除對模型性能影響微弱的冗余神經元。另一方面,為抑制欠擬合,可以增加隱藏神經元以提升模型的復雜性,或調整學習率、批量大小、正則化強度等超參數以改善性能。ML工程師必須平衡上述種種策略,并迭代評估DPD模型的性能,從而實現穩健且可泛化的模型,同時保證模型的執行速度。圖4顯示了神經網絡DPD模型評估系統架構的總體框圖。

圖4. 神經網絡DPD模型評估平臺的框圖。

在任何情況下,要確定隱藏神經元的最佳數量,必須依靠實證研究、反復試錯或在訓練過程中采用自適應方法。這些調整有助于確保神經網絡在復雜性和性能之間取得適當平衡,從而實現高效且有效的模型部署。在部署模型的過程中,采用邊緣AI嵌入式MCU,例如ADI公司的 MAX78000 卷積神經網絡加速器芯片,可以簡化模型的部署。

將人工智能和機器學習融入DPD系統,有望大幅提升系統性能,但也帶來了一些現實挑戰。DPD系統需要低延遲和高處理速度,而這對于計算密集型ML模型來說很難實現。此外,為了在溫度波動、硬件老化等動態運行條件下保持最佳性能,必須采用實時學習或遷移學習等自適應技術。

功耗是另一個關鍵考量因素。AI/ML模型(尤其是深度學習架構)往往比傳統DPD方法更耗電,因此不太適合對功耗敏感的環境。未來的實驗應該采用輕量級神經網絡,即標準神經網絡的優化版本。輕量級神經網絡在設計上減少了參數數量,降低了算力需求,并提高了內存利用效率,對于計算資源有限的應用特別有用,例如移動和物聯網(IoT)設備或其他資源受限的系統。

許多ML模型(尤其是深度神經網絡)缺乏可解釋性,進一步加劇了它們與DPD系統集成的復雜性。神經網絡模型將復雜的操作簡化為權重、偏置和激活函數,工作過程并不透明,因此調試和優化是相當困難的。

大規模MIMO等5G技術要求更低的功耗和更高的精度,DPD系統必須不斷發展以應對新的復雜性。通過自適應學習和混合建模等創新,AI/ML將為實現可擴展、高效節能的解決方案提供關鍵支持。神經網絡能夠模擬復雜的非線性關系和記憶效應,無需明確的數學公式就能近似處理非線性函數,讓DPD系統設計得以簡化。

集成AI/ML有助于提升能效比,使PA能夠在更接近飽和的狀態下工作,同時利用非線性PA降低成本。雖然存在挑戰,但AI/ML驅動的系統在增強DPD系統的精度、適應性和可擴展性方面潛力巨大。傳統多項式與AI/ML技術相結合的混合方法能夠提供一種均衡的解決方案,既保留了經典模型的可解釋性,又融合了AI/ML的先進能力。在AI/ML的助力下,通過創新策略應對種種挑戰,可以推動DPD系統取得突破性進展,進而支持現代通信技術的持續進步。

評論