如何在 Raspberry Pi 5 上運行 DeepSeek R1

你不能錯過這場地震事件,英偉達市值損失了 5890 億美元,因為在 DeepSeek 聲稱其開源 R1 模型可以提供競爭對手 OpenAI 的 o1 模型性能后,人們對 AI 的信心受到了打擊,用于訓練其最新模型的計算量減少了 11 倍。

(圖片來源:Tom's Hardware)

在我們深入研究這個如何做之前,讓我們先管理一下期望。是的,您可以在 Raspberry Pi 上運行 DeepSeek,但它受 CPU 限制,因此不要指望您的查詢在幾秒鐘內(nèi)完成。目前沒有官方的 AI 加速器 HAT 或插件可以加速模型。唯一的方法是將 GPU 連接到 Raspberry Pi 5 的 PCIe 連接器,可能使用 Pineboard 的 Hat UPCIty Lite 板和外部電源之一。

這意味著 Raspberry Pi 5 比我的臺式電腦處于劣勢,因為我的臺式電腦配備了 Nvidia RTX 4070 GPU。當 ollama 運行時,它會檢查 GPU,如果找到,它將使用它。所以我的 RTX 4070 正在做所有的工作。

測試

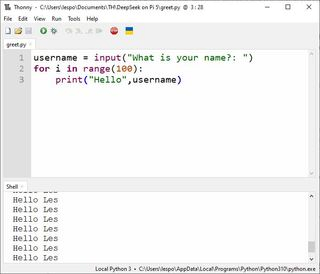

在本地運行 R1:8b,我想要一個簡單的測試,我想到的第一件事是編寫一些 Python 代碼。提示是:

“編寫一個 Python 腳本來詢問用戶的姓名,將其保存到一個名為 username 的變量中,然后用他們的名字問候用戶 100 次。”

(圖片來源:Tom's Hardware)

我通常如何解決這個問題?三行 Python 代碼,一行用于捕獲用戶輸入到變量,然后兩行用于創(chuàng)建打印個性化問候語的 for 循環(huán)。這是我教給數(shù)百名學生的基本初學者 Python,那么 AI 將如何解決它呢?

username = input("What is your name?: ")

for i in range(100):

print("Hello",username)

測試機 | 規(guī)格 | 所用時間 |

樹莓派 5 | 8GB LPDDR4X RAM,Broadcom BCM2712 2.4GHz 四核 64 位 Arm Cortex-A76 CPU | 8 分 01 秒 08 分鐘 |

AMD 銳龍 5 5600X | 32GB DDR4 內(nèi)存 AMD Ryzen 5 5600X 六核 3.7 / 4.6 GHz CPU Nvidia RTX 4070 GPU | 16.12 秒 |

Raspberry Pi 5 的代碼如下

username = input().strip

for _ in range(100):

print(f”Hello, {username}”)

捕獲用戶輸入,然后在將其分配給函數(shù)之前對其進行清理是明智之舉。該條帶將從捕獲的字符串中刪除任何空格。使用 f 字符串打印問候語是設置輸出格式的最新方法。在這種情況下,這有點多余,但我很高興看到學生嘗試這種方法。我對這段代碼的抱怨是沒有提示用戶輸入,因此在視頻中有短暫的延遲。值得慶幸的是,PC 沒有復制此問題。

在 PC 上,DeepSeek 生成了這段代碼。

username = input(“Enter your name: “)

for _ in range(100):

print(f”Hello, {username}!”)

用戶輸入被捕獲并保存到變量中,我們有一個輸入提示供用戶響應。其余部分與 Raspberry Pi 5 上的相同,只是多了一個 “!” 來強調(diào)問候語。

(圖片來源:Tom's Hardware)

你不能錯過 PC 和 Pi 5 之間的時差。所有這些都是離線的,依賴于運行它的設備的模型和 CPU/GPU。PC 在 16 秒內(nèi)完成了所有作,但 Pi 5 只用了 8 分鐘!哎呀,PC 是在 Pi 5 仍在加載模型時完成的。但是,在 Raspberry Pi 5 上運行 LLM 是一個有趣的實驗,值得花一點時間,所以讓我們在 Raspberry Pi 5 8GB 上安裝一個。請注意,Raspberry Pi 5 8GB 確實是我們嘗試的最低規(guī)格的 Pi 5。您可以嘗試使用經(jīng)過調(diào)整型號的 4GB Pi 5,但您的里程會有所不同!

通過 ollama 在 Raspberry Pi 5 上設置 DeepSeek

為了簡化作,我們將通過 ollama 設置 DeepSeek,這是一個免費的開源工具,任何人都可以在自己的計算機上運行大型語言模型 (LLM)。

我們將使用的模型是蒸餾的 Llama 模型,它適合我們的 Raspberry Pi 8 提供的 5GB RAM。

ollama 團隊表示,“DeepSeek 團隊已經(jīng)證明,較大模型的推理模式可以提煉成更小的模型,與通過 RL 在小型模型上發(fā)現(xiàn)的推理模式相比,性能更好。為什么我們用這個模型而不是“真正的”DeepSeek 模型呢?僅僅因為 deepseek-r1:671b 模型的大小為 404GB,它顯然會壓倒 Raspberry Pi 5。

借助 ollama 的腳本,在 Raspberry Pi 上安裝變得輕而易舉。

1. 打開終端并確保您的 Raspberry Pi 5 正在運行最新的軟件。

sudo apt update

sudo apt upgrade -y

2. 下載并安裝 ollama 安裝腳本。通常,使用來自 Internet 的腳本安裝軟件是一個主要的 No No。我們絕不會在生產(chǎn)環(huán)境中這樣做。如果您好奇,可以將 install.sh 保存到文件中,并在使用前讀取內(nèi)容。

curl -fsSL https://ollama.com/install.sh | sh

3. 檢查版本號。我們的版本是 0.5.7,但考慮到 LLM 的快速發(fā)展,您的版本可能會有所不同。如果您需要記錄任何問題或搜索特定指南,了解您安裝的版本號總是很方便的。

ollama --version

4. 下載并運行 DeepSeek-r1:8b。這是一個蒸餾的 Llama 模型,適合我們的 Raspberry Pi 8 提供的 5GB RAM。

ollama run deepseek-r1:8b

5. 等待下載和安裝完成。這一開始可能需要一些時間,但后續(xù)加載應該要快得多。

6. 用戶界面很簡單,只需輸入請求/查詢,LLM 就會解釋和響應。慢慢。

7. 完成后,您可以按 CTRL + D 或鍵入 /bye 并按 Enter 鍵關(guān)閉會話。

Raspberry Pi 5 上的 DeepSeek 完全受 CPU 限制。它不能與任何 AI 加速器板一起使用。如果您具備知識和設備,可以通過 Raspberry Pi 5 上的 PCIe 連接器將其與 GPU 一起使用。由于缺乏設備,我們無法對此進行測試,但永遠無所畏懼的 Jeff Geerling 肯定會在不久的將來對此進行測試。

評論