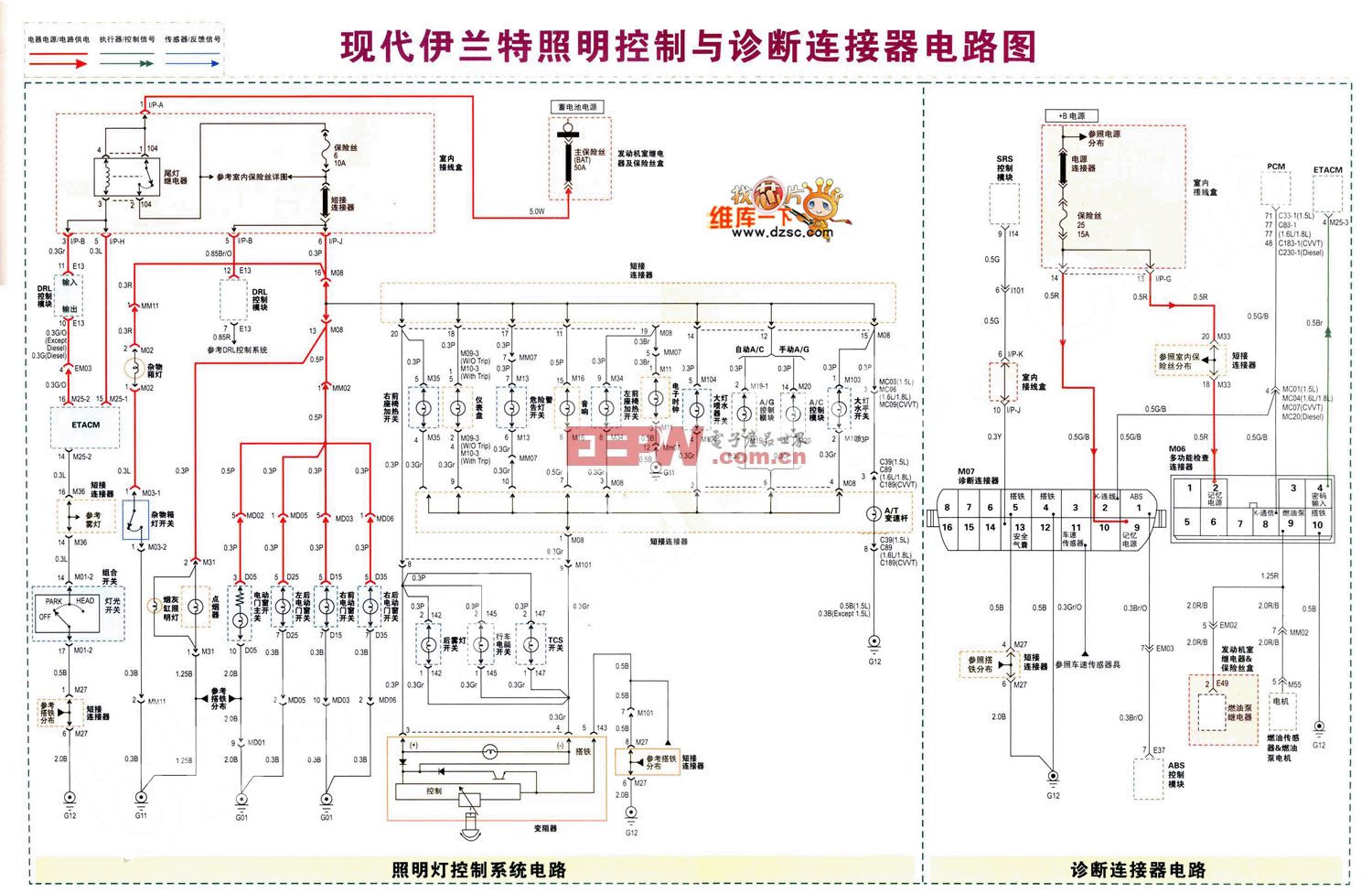

什么類型連接器用于連接AI數據中心的加速卡?

許多數據中心都配備了高性能圖形處理單元 (GPU) 和張量處理單元 (TPU) 機架。這些加速器處理海量人工智能 (AI) 和機器學習 (ML) 數據集,并行執行復雜作并高速交換數據。本文探討了將 AI 加速器集群鏈接在一起的互連和連接器。

本文引用地址:http://www.czjhyjcfj.com/article/202505/470863.htm使用加速器和集群架構擴展 AI 計算

GPU、TPU 等 AI 加速器,以及在某些情況下的現場可編程門陣列 (FPGA),使用并行處理來運行大型語言模型 (LLM),以大規模處理復雜的計算。這些設備將復雜的工作負載劃分為更小的任務,并同時執行數十億次作。大多數 AI 模型都建立在神經網絡之上,神經網絡受益于這種大規模并行架構,可以加速訓練和推理。

如圖 1 所示,AI 加速器通常部署在緊密耦合的集群中,以有效地共享數據、同步計算并在數千個處理單元之間擴展訓練。

圖 1.Google 數據中心包含用于大規模機器學習工作負載的緊密耦合 AI 加速器機架。此處顯示的是 TPU v4 基礎架構的圖示。(圖片:谷歌))

圖 1.Google 數據中心包含用于大規模機器學習工作負載的緊密耦合 AI 加速器機架。此處顯示的是 TPU v4 基礎架構的圖示。(圖片:谷歌))

此配置有助于滿足 AI 工作負載的低延遲、高性能需求。它還可以提高吞吐量,最大限度地減少瓶頸,并支持對復雜的計算密集型任務進行實時推理。

高級互連架構和協議

數據中心使用專門的互連技術來鏈接 AI 加速器集群,以實現大規模高效運行,從而在節點內部和節點之間實現高速通信。這些互連支持海量數據交換、同步處理和復雜工作負載的并行執行。常見的 AI 加速器互連包括:

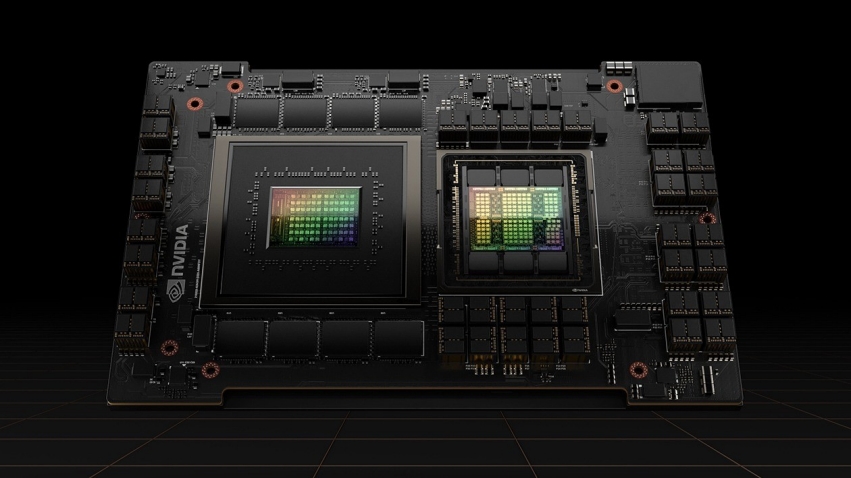

NVLink — NVIDIA 專有的高帶寬互連有助于實現 GPU 到 GPU 的直接通信,具有低延遲和高能效。它支持使用專用連接器和 NVSwitch 技術在加速器之間快速同步和數據共享。NVLink 通過啟用內存池在多 GPU 環境中高效擴展,允許 GPU 共享統一的地址空間并作為單個高性能計算單元運行。如圖 2 所示, NVLink 4.0 在 H100 GPU 上提供高達 900 GB / s 的雙向帶寬。

圖 2.Nvidia 的 H100 GPU 使用 NVLink 4.0 實現高達 900 GB/s 的雙向帶寬,可在多加速器集群中實現高速 GPU 到 GPU 通信。(圖片:英偉達)

圖 2.Nvidia 的 H100 GPU 使用 NVLink 4.0 實現高達 900 GB/s 的雙向帶寬,可在多加速器集群中實現高速 GPU 到 GPU 通信。(圖片:英偉達)

UALink — Ultra Accelerator Link 是一種開放式互連標準,旨在在單個計算 Pod 中擴展多達 1024 個 AI 加速器的集群。1.0 規范支持每通道 200G,并實現具有以太網級帶寬和 PCIe 級延遲的密集內存語義連接。UALink 支持跨節點的讀、寫和原子事務,并為可擴展的多節點系統定義了一個通用協議棧。UALink 被定位為在加速器 Pod 內擴展的高性能替代方案,其目標是比典型的以太網更低的延遲來實現節點間通信。

Compute Express Link (CXL) 可在 CPU、GPU 和其他加速器之間實現連貫的低延遲通信。它通過支持緩存一致性、內存池化、資源共享和內存分解來提高異構系統中的資源利用率。CXL 1.1 和 2.0 在 PCIe 5.0 上運行,而 CXL 3.0 及更高版本利用 PCIe 6.0 或更高版本,實現高達 64 GT/s 的傳輸速度和 128 GB/s 的雙向帶寬。

高速以太網有助于在分布在服務器和節點上的加速器集群之間移動數據。400 GbE 和 800 GbE 等技術支持使用 NIC 和光纜或銅纜進行高吞吐量通信。雖然以太網比 NVLink 或 UALink 引入更高的延遲,但它在機架和數據中心級別提供了廣泛的互作性和靈活的部署。

光互連和外形尺寸;光纖鏈路可遠距離高速傳輸數據,跨機架和節點鏈接加速器集群。與銅纜連接相比,它們消耗的功率更少,并克服了信號完整性挑戰,如衰減和 EMI。這些互連通常依賴于標準化的外形尺寸,例如四通道小型可插拔 (QSFP)、四通道小型可插拔雙密度 (QSFP-DD) 和八通道小型可插拔 (OSFP),它們用作電氣和光纖以太網連接的物理接口。這些相同的外形尺寸也廣泛用于數據中心中的其他高速光互連,例如 InfiniBand 和專有光鏈路,進一步擴展了它們在可擴展計算基礎設施中的作用。

AI 加速器的物理連接器和接口

高性能互連依賴于各種物理層組件,包括連接器、插槽和布線接口。這些組件有助于保持信號完整性、機械兼容性和可擴展的系統設計。它們跨電路板、設備和系統傳輸電信號和光信號,促進集群 AI 基礎設施的可靠運行。

盡管互連定義了通信協議和信號標準,但它們依賴于這些物理接口才能大規模有效地運行。常見的連接器和接口技術如下所述。

PCIe 接口將加速器卡連接到主機系統和其他組件。盡管新一代(如 PCIe 5.0 和 6.0)提供可擴展的帶寬,但它們可能會在緊密耦合的多加速器環境中成為瓶頸。重定時器通常用于在較長的電路板走線上保持信號完整性。

夾層連接器用于 Open Compute Project 的 Open Accelerator Infrastructure (OAI)。它們支持高密度模塊到模塊連接,減少信號損耗,管理阻抗,并簡化模塊化加速器設計中的機械集成。

有源電纜 (AEC) 將數字信號處理器集成到銅纜中,以提高更遠距離的信號強度。這使得電氣鏈路能夠在無源電纜無法觸及的地方保持數據完整性。

高速板對板連接器使用 PAM4 調制,以高達 224 Gbps 的數據速率實現直接模塊通信。它們支持 AI 平臺和緊密集成的加速器集群內的密集、低延遲通信。

光纖連接器 — QSFP、QSFP-DD 和 OSFP 外形規格是光纖和短距離電氣以太網連接的物理接口。這些收發器格式廣泛部署在 NIC、交換機端口和光模塊上,并支持 PAM4 調制,以保持各種部署場景中的信號性能。

液冷連接器

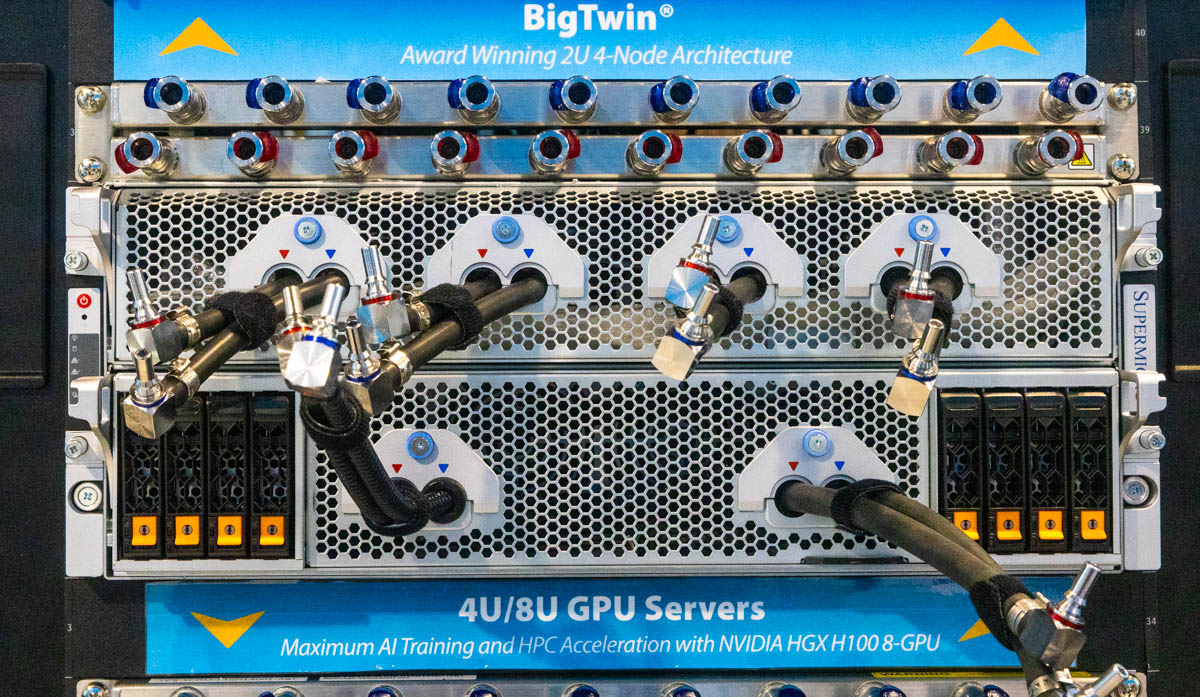

如圖 3 所示,越來越多的高性能 AI 加速器機架依賴于液體冷卻。這些系統中使用的許多連接器必須滿足嚴格的機械和熱要求,以確保安全、可靠的運行。

圖 3.液冷 GPU 服務器,具有集成的快速斷開接頭和歧管連接,適用于高密度 AI 訓練工作負載。這些連接器經過精心設計,可在 NVIDIA HGX H100 平臺等系統中支持安全、高吞吐量的冷卻。(圖片:Supermicro)

圖 3.液冷 GPU 服務器,具有集成的快速斷開接頭和歧管連接,適用于高密度 AI 訓練工作負載。這些連接器經過精心設計,可在 NVIDIA HGX H100 平臺等系統中支持安全、高吞吐量的冷卻。(圖片:Supermicro)

這些連接器通常可承受高達 50°C (122°F) 的溫度,支持高達 13 升/分鐘 (LPM) 的冷卻劑流速,并保持約 0.25 磅/平方英寸 (psi) 的低壓降。它們使用水基和介電流體提供無泄漏作,防止腐蝕,并可輕松與機架內歧管集成。

大多數液冷連接器都包含快速斷開功能,可實現無滴漏維護。大內徑(通常約為 5/8 英寸)支持跨 AI 機架的高流速。有些提供將高速數據傳輸與液體冷卻通道相結合的混合設計。其他產品支持與 3 英寸見方的不銹鋼管兼容,或采用堅固的結構,以承受溫度波動、壓力變化和振動。

總結

AI 數據中心依靠各種互連和物理連接器來鏈接加速卡,實現高速數據交換,并促進大規模并行處理。這些組件對于在緊密耦合的集群中保持性能、信號完整性和機械可靠性至關重要。

評論