大模型市場(chǎng),不止帶火HBM

近日,HBM 成為芯片行業(yè)的火熱話題。據(jù) TrendForce 預(yù)測(cè),2023 年高帶寬內(nèi)存(HBM)比特量預(yù)計(jì)將達(dá)到 2.9 億 GB,同比增長(zhǎng)約 60%,2024 年預(yù)計(jì)將進(jìn)一步增長(zhǎng) 30%。2008 年被 AMD 提出的 HBM 內(nèi)存概念,在 2013 年被 SK 海力士通過 TSV 技術(shù)得以實(shí)現(xiàn),問世 10 年后 HBM 似乎真的來到了大規(guī)模商業(yè)化的時(shí)代。

HBM 的概念的起飛與 AIGC 的火爆有直接關(guān)系。AI 服務(wù)器對(duì)帶寬提出了更高的要求,與 DDR SDRAM 相比,HBM 具有更高的帶寬和更低的能耗。超高的帶寬讓 HBM 成為了高性能 GPU 的核心組件,HBM 基本是 AI 服務(wù)器的標(biāo)配。目前,HBM 成本在 AI 服務(wù)器成本中占比排名第三,約占 9%,單機(jī)平均售價(jià)高達(dá) 18,000 美元。

自從去年 ChatGPT 出現(xiàn)以來,大模型市場(chǎng)就開始了高速增長(zhǎng),國(guó)內(nèi)市場(chǎng)方面,百度、阿里、科大訊飛、商湯、華為等科技巨頭接連宣布將訓(xùn)練自己的 AI 大模型。TrendForce 預(yù)測(cè),2025 年將有 5 個(gè)相當(dāng)于 ChatGPT 的大型 AIGC、25 個(gè) Midjourney 的中型 AIGC 產(chǎn)品、80 個(gè)小型 AIGC 產(chǎn)品,即使是全球所需的最小計(jì)算能力資源也可能需要 145,600 至 233,700 個(gè)英偉達(dá) A100 GPU。這些都是 HBM 的潛在增長(zhǎng)空間。

2023 年開年以來,三星、SK 海力士 HBM 訂單就快速增加,HBM 的價(jià)格也水漲船高,近期 HBM3 規(guī)格 DRAM 價(jià)格上漲了 5 倍。三星已收到 AMD 與英偉達(dá)的訂單,以增加 HBM 供應(yīng)。SK 海力士已著手?jǐn)U建 HBM 產(chǎn)線,目標(biāo)將 HBM 產(chǎn)能翻倍。韓媒報(bào)道,三星計(jì)劃投資約 7.6 億美元擴(kuò)產(chǎn) HBM,目標(biāo)明年底之前將 HBM 產(chǎn)能提高一倍,公司已下達(dá)主要設(shè)備訂單。

HBM 在 AIGC 中的優(yōu)勢(shì)

直接地說,HBM 將會(huì)讓服務(wù)器的計(jì)算能力得到提升。由于短時(shí)間內(nèi)處理大量數(shù)據(jù),AI 服務(wù)器對(duì)帶寬提出了更高的要求。HBM 的作用類似于數(shù)據(jù)的「中轉(zhuǎn)站」,就是將使用的每一幀、每一幅圖像等圖像數(shù)據(jù)保存到幀緩存區(qū)中,等待 GPU 調(diào)用。與傳統(tǒng)內(nèi)存技術(shù)相比,HBM 具有更高帶寬、更多 I/O 數(shù)量、更低功耗、更小尺寸,能夠讓 AI 服務(wù)器在數(shù)據(jù)處理量和傳輸速率有大幅提升。

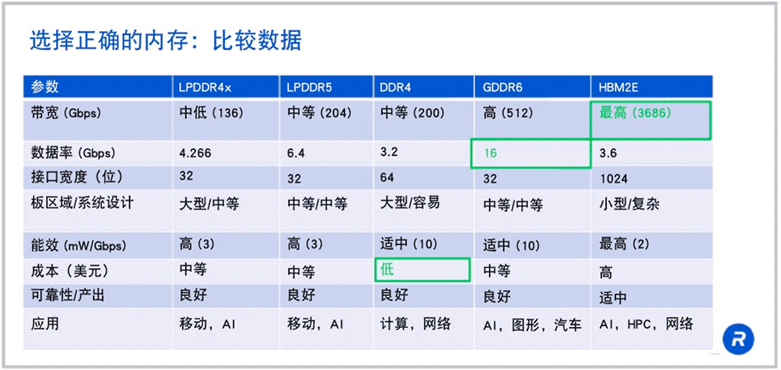

來源:rambus

可以看到 HBM 在帶寬方面有著「碾壓」級(jí)的優(yōu)勢(shì)。如果 HBM2E 在 1024 位寬接口上以 3.6Gbps 的速度運(yùn)行,那么就可以得到每秒 3.7Tb 的帶寬,這是 LPDDR5 或 DDR4 帶寬的 18 倍以上。

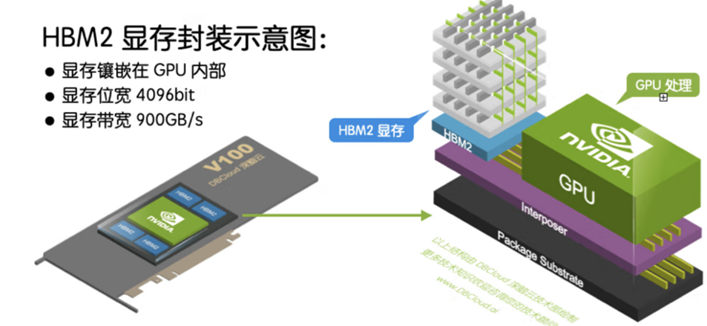

除了帶寬優(yōu)勢(shì),HBM 可以節(jié)省面積,進(jìn)而在系統(tǒng)中安裝更多 GPU。HBM 內(nèi)存由與 GPU 位于同一物理封裝上的內(nèi)存堆棧組成。

這樣的架構(gòu)意味著與傳統(tǒng)的 GDDR5/6 內(nèi)存設(shè)計(jì)相比,可節(jié)省大量功耗和面積,從而允許系統(tǒng)中安裝更多 GPU。隨著 HPC、AI 和數(shù)據(jù)分析數(shù)據(jù)集的規(guī)模不斷增長(zhǎng),計(jì)算問題變得越來越復(fù)雜,GPU 內(nèi)存容量和帶寬也越來越大是一種必需品。H100 SXM5 GPU 通過支持 80 GB(五個(gè)堆棧)快速 HBM3 內(nèi)存,提供超過 3 TB/秒的內(nèi)存帶寬,是 A100 內(nèi)存帶寬的 2 倍。

過去對(duì)于 HBM 來說,價(jià)格是一個(gè)限制因素。但現(xiàn)在大模型市場(chǎng)上正處于百家爭(zhēng)鳴時(shí)期,對(duì)于布局大模型的巨頭們來說時(shí)間就是金錢,因此「貴有貴的道理」的 HBM 成為了大模型巨頭的新寵。隨著高端 GPU 需求的逐步提升,HBM 開始成為 AI 服務(wù)器的標(biāo)配。

目前英偉達(dá)的 A100 及 H100,各搭載達(dá) 80GB 的 HBM2e 及 HBM3,在其最新整合 CPU 及 GPU 的 Grace Hopper 芯片中,單顆芯片 HBM 搭載容量再提升 20%,達(dá) 96GB。

AMD 的 MI300 也搭配 HBM3,其中,MI300A 容量與前一代相同為 128GB,更高端 MI300X 則達(dá) 192GB,提升了 50%。

預(yù)期 Google 將于 2023 年下半年積極擴(kuò)大與 Broadcom 合作開發(fā) AISC AI 加速芯片 TPU 也計(jì)劃搭載 HBM 存儲(chǔ)器,以擴(kuò)建 AI 基礎(chǔ)設(shè)施。

存儲(chǔ)廠商加速布局

這樣的「錢景」讓存儲(chǔ)巨頭們加速對(duì) HBM 內(nèi)存的布局。目前,全球前三大存儲(chǔ)芯片制造商正將更多產(chǎn)能轉(zhuǎn)移至生產(chǎn) HBM,但由于調(diào)整產(chǎn)能需要時(shí)間,很難迅速增加 HBM 產(chǎn)量,預(yù)計(jì)未來兩年 HBM 供應(yīng)仍將緊張。

HBM 的市場(chǎng)主要還是被三大 DRAM 巨頭把握。不過不同于 DRAM 市場(chǎng)被三星領(lǐng)先,SK 海力士在 HBM 市場(chǎng)上發(fā)展的更好。如開頭所說,SK 海力士開發(fā)了第一個(gè) HBM 產(chǎn)品。2023 年 4 月,SK 海力士宣布開發(fā)出首個(gè) 24GB HBM3 DRAM 產(chǎn)品,該產(chǎn)品用 TSV 技術(shù)將 12 個(gè)比現(xiàn)有芯片薄 40% 的單品 DRAM 芯片垂直堆疊,實(shí)現(xiàn)了與 16GB 產(chǎn)品相同的高度。同時(shí),SK 海力士計(jì)劃在 2023 年下半年準(zhǔn)備具備 8Gbps 數(shù)據(jù)傳輸性能的 HBM3E 樣品,并將于 2024 年投入量產(chǎn)。

國(guó)內(nèi)半導(dǎo)體公司對(duì) HBM 的布局大多圍繞著封裝及接口領(lǐng)域。

國(guó)芯科技目前正在研究規(guī)劃合封多 HBM 內(nèi)存的 2.5D 的芯片封裝技術(shù),積極推進(jìn) Chiplet 技術(shù)的研發(fā)和應(yīng)用。

通富微電公司 2.5D/3D 生產(chǎn)線建成后,將實(shí)現(xiàn)國(guó)內(nèi)在 HBM 高性能封裝技術(shù)領(lǐng)域的突破。

佰維存儲(chǔ)已推出高性能內(nèi)存芯片和內(nèi)存模組,將保持對(duì) HBM 技術(shù)的持續(xù)關(guān)注。

瀾起科技 PCIe 5.0/CXL 2.0 Retimer 芯片實(shí)現(xiàn)量產(chǎn),該芯片是瀾起科技 PCIe 4.0 Retimer 產(chǎn)品的關(guān)鍵升級(jí),可為業(yè)界提供穩(wěn)定可靠的高帶寬、低延遲 PCIe 5.0/ CXL 2.0 互連解決方案。

HBM 雖好但仍需冷靜,HBM 現(xiàn)在依舊處于相對(duì)早期的階段,其未來還有很長(zhǎng)的一段路要走。而可預(yù)見的是,隨著越來越多的廠商在 AI 和機(jī)器學(xué)習(xí)等領(lǐng)域不斷發(fā)力,內(nèi)存產(chǎn)品設(shè)計(jì)的復(fù)雜性正在快速上升,并對(duì)帶寬提出了更高的要求,不斷上升的寬帶需求將持續(xù)驅(qū)動(dòng) HBM 發(fā)展。

HBM 火熱反映了 AIGC 的帶動(dòng)能力。那么除了 HBM 和 GPU,是否還有別的產(chǎn)品在這波新風(fēng)潮中能夠順勢(shì)發(fā)展?

談?wù)勂渌粠Щ鸬男酒?/span>

FPGA 的優(yōu)勢(shì)開始顯現(xiàn)

FPGA(Field Programmable Gate Array,現(xiàn)場(chǎng)可編程門陣列)是一種集成電路,具有可編程的邏輯元件、存儲(chǔ)器和互連資源。不同于 ASIC(專用集成電路),F(xiàn)PGA 具備靈活性、可定制性、并行處理能力、易于升級(jí)等優(yōu)勢(shì)。

通過編程,用戶可以隨時(shí)改變 FPGA 的應(yīng)用場(chǎng)景,F(xiàn)PGA 可以模擬 CPU、GPU 等硬件的各種并行運(yùn)算。因此,在業(yè)內(nèi)也被稱為「萬能芯片」。

FPGA 對(duì)底層模型頻繁變化的人工智能推理需求很有意義。FPGA 的可編程性超過了 FPGA 使用的典型經(jīng)濟(jì)性。需要明確的是,F(xiàn)PGA 不會(huì)成為使用數(shù)千個(gè) GPU 的大規(guī)模人工智能系統(tǒng)的有力競(jìng)爭(zhēng)對(duì)手,但隨著人工智能進(jìn)一步滲透到電子領(lǐng)域,F(xiàn)PGA 的應(yīng)用范圍將會(huì)擴(kuò)大。

FPGA 相比 GPU 的優(yōu)勢(shì)在于更低的功耗和時(shí)延。GPU 無法很好地利用片上內(nèi)存,需要頻繁讀取片外的 DRAM,因此功耗非常高。FPGA 可以靈活運(yùn)用片上存儲(chǔ),因此功耗遠(yuǎn)低于 GPU。

6 月 27 日,AMD 宣布推出 AMD Versal Premium VP1902 自適應(yīng)片上系統(tǒng)(SoC),是基于 FPGA 的自適應(yīng) SoC。這是一款仿真級(jí)、基于小芯片的設(shè)備,能夠簡(jiǎn)化日益復(fù)雜的半導(dǎo)體設(shè)計(jì)的驗(yàn)證。據(jù)悉,AMD VP1902 將成為全球最大的 FPGA,對(duì)比上一代產(chǎn)品(Xilinx VU19P),新的 VP1902 增加了 Versal 功能,并采用了小芯片設(shè)計(jì),使 FPGA 的關(guān)鍵性能增加了一倍以上。

東興證券研報(bào)認(rèn)為,F(xiàn)PGA 憑借其架構(gòu)帶來的時(shí)延和功耗優(yōu)勢(shì),在 AI 推理中具有非常大的優(yōu)勢(shì)。浙商證券此前研報(bào)亦指出,除了 GPU 以外,CPU+FPGA 的方案也能夠滿足 AI 龐大的算力需求。

不同于 HBM 被海外公司壟斷,國(guó)內(nèi)公司 FPGA 芯片已經(jīng)有所積累。

安路科技主營(yíng)業(yè)務(wù)為 FPGA 芯片和專用 EDA 軟件的研發(fā)、設(shè)計(jì)和銷售,產(chǎn)品已廣泛應(yīng)用于工業(yè)控制、網(wǎng)絡(luò)通信、消費(fèi)電子等領(lǐng)域。紫光國(guó)微子公司紫光同創(chuàng)是專業(yè)的 FPGA 公司,設(shè)計(jì)和銷售通用 FPGA 芯片。紫光國(guó)微曾在業(yè)績(jī)說明會(huì)上表示,公司的 FPGA 芯片可以用于 AI 領(lǐng)域。東土科技主要開展 FPGA 芯片的產(chǎn)業(yè)化工作,公司參股公司中科億海微團(tuán)隊(duì)自主開發(fā)了支撐其 FPGA 產(chǎn)品應(yīng)用開發(fā)的 EDA 軟件。

國(guó)產(chǎn)替代新思路:存算一體+Chiplet

能否利用我們現(xiàn)在可用的工藝和技術(shù)來開發(fā)在性能上可以跟英偉達(dá)對(duì)標(biāo)的 AI 芯片呢?一些「新思路」出現(xiàn)了,例如存算一體+Chiplet。

存算分離會(huì)導(dǎo)致算力瓶頸。AI 技術(shù)的快速發(fā)展,使得算力需求呈爆炸式增長(zhǎng)。在后摩爾時(shí)代,存儲(chǔ)帶寬制約了計(jì)算系統(tǒng)的有效帶寬,系統(tǒng)算力增長(zhǎng)步履維艱。例如,8 塊 1080TI 從頭訓(xùn)練 BERT 模型需 99 天。存算一體架構(gòu)沒有深度多層級(jí)存儲(chǔ)的概念,所有的計(jì)算都放在存儲(chǔ)器內(nèi)實(shí)現(xiàn),從而消除了因?yàn)榇嫠惝悩?gòu)帶來的存儲(chǔ)墻及相應(yīng)的額外開銷;存儲(chǔ)墻的消除可大量減少數(shù)據(jù)搬運(yùn),不但提升了數(shù)據(jù)傳輸和處理速度,而且能效比得以數(shù)倍提升。

一方面,存算一體架構(gòu)與傳統(tǒng)架構(gòu)處理器處理同等算力所需的功耗會(huì)降低;另一方面,存算一體的數(shù)據(jù)狀態(tài)都是編譯器可以感知的,因此編譯效率很高,可以繞開傳統(tǒng)架構(gòu)的編譯墻。

美國(guó)亞利桑那州立大學(xué)的學(xué)者于 2021 年發(fā)布了一種基于 Chiplet 的 IMC 架構(gòu)基準(zhǔn)測(cè)試仿真器 SIAM, 用于評(píng)估這種新型架構(gòu)在 AI 大模型訓(xùn)練上的潛力。SIAM 集成了器件、電路、架構(gòu)、片上網(wǎng)絡(luò) (NoC)、封裝網(wǎng)絡(luò) (NoP) 和 DRAM 訪問模型,以實(shí)現(xiàn)一種端到端的高性能計(jì)算系統(tǒng)。SIAM 在支持深度神經(jīng)網(wǎng)絡(luò) (DNN) 方面具有可擴(kuò)展性,可針對(duì)各種網(wǎng)絡(luò)結(jié)構(gòu)和配置進(jìn)行定制。其研究團(tuán)隊(duì)通過使用 CIFAR-10、CIFAR-100 和 ImageNet 數(shù)據(jù)集對(duì)不同的先進(jìn) DNN 進(jìn)行基準(zhǔn)測(cè)試來展示 SIAM 的靈活性、可擴(kuò)展性和仿真速度。據(jù)稱,相對(duì)于英偉達(dá) V100 和 T4 GPU, 通過 SIAM 獲得的 chiplet +IMC 架構(gòu)顯示 ResNet-50 在 ImageNet 數(shù)據(jù)集上的能效分別提高了 130 和 72。

這意味著,存算一體 AI 芯片有希望借助 Chiplet 技術(shù)和 2.5D / 3D 堆疊封裝技術(shù)實(shí)現(xiàn)異構(gòu)集成,從而形成大型計(jì)算系統(tǒng)。存算一體 + Chiplet 組合似乎是一種可行的實(shí)現(xiàn)方式,據(jù)稱億鑄科技正在這條路上探索,其第一代存算一體 AI 大算力商用芯片可實(shí)現(xiàn)單卡算力 500T 以上,功耗在 75W 以內(nèi)。也許這將開啟 AI 算力第二增長(zhǎng)曲線的序幕。

結(jié)語

世界人工智能大會(huì)上,AMD CEO 蘇姿豐表示,未來十年一定會(huì)出現(xiàn)一個(gè)大型計(jì)算超級(jí)周期,因此,目前正是一個(gè)成為技術(shù)供應(yīng)商的好時(shí)機(jī),同時(shí)也是與一些將會(huì)利用這些技術(shù)開發(fā)不同應(yīng)用的客戶合作的好時(shí)機(jī)。

沒有人想要一個(gè)只有一個(gè)主導(dǎo)者的行業(yè)。大模型市場(chǎng)能否讓芯片行業(yè)擁有新的市場(chǎng)格局,能否讓新玩家出現(xiàn)?

「大模型市場(chǎng)對(duì)芯片行業(yè)帶來了新的市場(chǎng)格局和機(jī)會(huì)。通過推動(dòng) AI 芯片的發(fā)展、促進(jìn)云計(jì)算和數(shù)據(jù)中心市場(chǎng)的增長(zhǎng)以及引發(fā)競(jìng)爭(zhēng)格局變化,大模型的興起為芯片行業(yè)帶來了新的發(fā)展方向。

需要注意的是,芯片行業(yè)是一個(gè)高度競(jìng)爭(zhēng)和技術(shù)密集的行業(yè)。進(jìn)入該行業(yè)需要龐大的資金和技術(shù)資源,以滿足復(fù)雜的制造和研發(fā)要求。盡管大模型市場(chǎng)為新玩家提供了機(jī)會(huì),但他們需要克服技術(shù)、資金和市場(chǎng)等方面的挑戰(zhàn),才能在競(jìng)爭(zhēng)激烈的芯片行業(yè)中獲得成功。」Chatgpt 如是回應(yīng)。

評(píng)論