Agility Robotics 解釋了如何訓練全身控制基礎模型

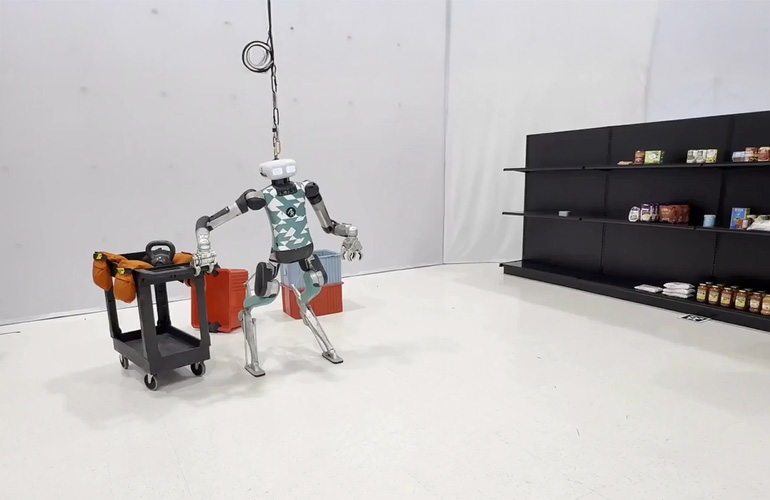

Agility Robotics 為其 Digit 仿人型機器人開發了一個全身控制基礎模型。來源:Agility Robotics

根據最近 Agility Robotics 的博客文章,仿人型機器人最顯著的優勢是能夠在高度受限的環境中執行各種任務。建成世界是為人而設計的,能夠匹配我們一般能力的機器將是最有價值的。

當然,這并不意味著仿人型機器人必須長得和我們一樣,公司之前已經解釋過了。

任務目標相對明確,但執行工作卻面臨各種挑戰。機器人必須保持平衡,平穩移動,并對外部環境干擾具有魯棒性,同時還要以極高的精度進行抓取、握持和操作。最重要的是,機器人絕不能摔倒。

Agility Robotics 為 Digit 賦予了“運動皮層”

為此,Agility Robotics 為其 Digit 人類機器人開發了一個全身控制基礎模型,以確保其在執行各種任務時保持安全和穩定。它就像人類大腦中的運動皮層一樣,接收來自大腦不同部分的信號——在 Digit 的情況下,是 Agility 的控制層次結構的不同級別——以控制自主運動和精細運動技能。

該模型是一個相對較小的 LSTM(長短期記憶)神經網絡,參數少于 100 萬個,在 NVIDIA 的 Isaac Sim 物理 模擬器 中進行了訓練,模擬時間長達數十年,訓練時間為三到四天。

Digit 的運動皮層完全在模擬中學習,并且可以零樣本遷移到現實世界。它可以被提示使用手臂和軀干的密集自由空間位置和方向目標來實現不同的目標,包括行走和拾取和放置重物。它可以在運動皮層之上學習下游靈巧操作技能,并且類似地使用大型語言模型(LLMs)協調復雜行為。

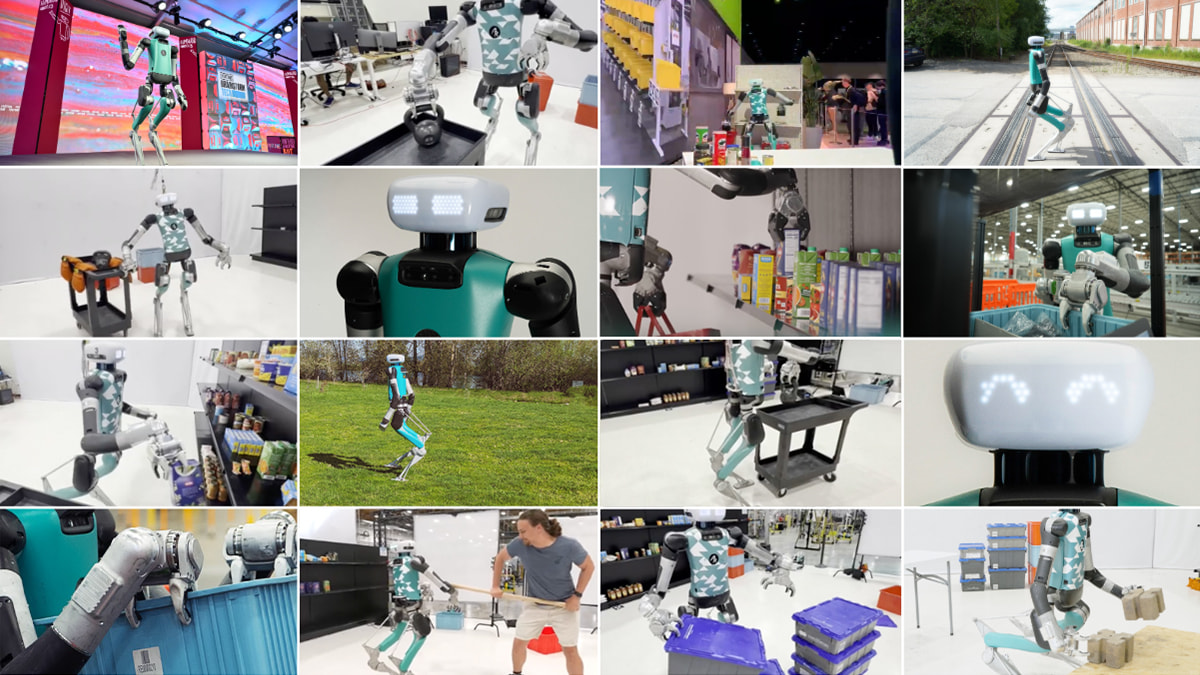

Agility Robotics 可以使用多種方法提示其模型,以完成一系列多樣化的任務。

三月份,該公司在其早期版本的工作中,在 NVIDIA 的 GTC 活動上展示了 Digit 購物。在這個演示中,策略是由一個開放詞匯對象檢測器提示的,然后被提升到 3D,執行通過狀態機規劃循環管理:

Digit 在 NVIDIA GTC 上展示了雜貨處理能力。來源:Agility Robotics

Agility 表示,這是使 Digit 在執行復雜操作計劃時更加抗干擾的重要一步。該公司還使用 Gemini 研究預覽提示了運動皮層:

該控制器也能穩健地拿起非常重的物體:

來源:Agility Robotics

為什么這很難?

Agility Robotics 表示,為了執行有用的工作,機器人必須能夠在其末端執行器在世界中穩健地定位和移動。對于固定基座機器人來說,這是一個已經得到充分理解的問題;幾十年來,人們已經廣泛使用基于模型的算法,如逆運動學(IK)或逆動力學(ID)的簡單控制器,取得了極大的成效。

從使用這種系統的用戶的角度來看,他們只需要提供末端執行器的期望姿態,固定基座機器人就會迅速移動以匹配該目標姿態。

Agility 表示希望為仿人機器人創建相同的接口:機器人只需通過其末端執行器的期望運動即可獲得信息,然后機器人快速高效地定位自身以實現這些目標。

不幸的是,這種能力在腿式機器人上并不簡單,它表示。腿式行走的物理特性有兩種模式:一種是腿在空中自由擺動,另一種是腿著地并對機器人的其余部分施加力。這兩種物理特性由“接觸”或“斷開接觸”的概念分開,這發生在機器人放置腳或抬起腳離開地面時。

這種復雜性帶來了巨大的計算成本,為了簡化控制和規劃問題,幾乎總是采用簡化假設。一種常見的簡化假設是,在末端執行器達到目標或操縱世界中的物體時,機器人的腿將保持與地面的接觸——實際上將腿式平臺變成固定基座平臺。

Agility Robotics 表示,這是一個強大的啟發式方法,是機器人領域最近許多令人印象深刻的進步的基礎,但也是一個限制現代機器人性能的基本限制。防止機器人動態調整其腳部位置將限制其操作工作空間,并阻止其智能自然地應對工作過程中可能遇到的干擾力。

更理想的界面應該是機器人簡單地跟蹤用戶期望的手部動作,在必要時自行行走,避免與環境的碰撞,并努力不摔倒。在實時生成動態可行的全身運動計劃方面的難度,使這種界面對于人形機器人來說,直到最近一直是不可能實現的。

進入強化學習

深度強化學習(RL)正迅速成為人形機器人的主導控制范式。它不是在控制器中顯式地模擬機器人混合動力學的運動方程,也不是對整個系統的接觸狀態做出簡化假設,而是在物理模擬器中訓練一個神經網絡,使其作為控制器來跟蹤全身運動,然后將該神經網絡部署在硬件上。

最近關于人形全身控制的研究成果令人印象深刻,具有高度動態性,并且與使用更傳統的基于模型的控制方法相比,在硬件上實現工作所需的專業知識和精力要少得多。然而,這些研究大多集中在動態全身運動上,如舞蹈,而未能實現移動操作所需的精確跟蹤。

Agility Robotics 正專注于雙手和雙腳施加力的能力,以便 Digit 能夠抬起和移動重物。

控制器必須覆蓋工作空間

大多數現有的使用強化學習(如 GMT 或 TWIST)訓練人形機器人全身控制器的工作都使用大型離線數據集,例如 AMASS 或 LAFAN1 來訓練全身控制網絡。這已經取得了一些非常令人印象深刻和逼真的結果,但這些軌跡分布通常無法覆蓋整個所需的手部操作空間,Agility Robotics 觀察到。

不可避免地,這些離線數據集中的手部姿態目標將密集覆蓋工作空間中的一些代表性區域,而工作空間的極端區域或其他關鍵區域則分布稀疏。然而,Agility 堅持認為,手部目標的訓練分布必須均勻覆蓋整個工作空間,以確保機器人能夠可靠地執行利用其整個范圍進行復雜操作。

為了確保其運動皮層能夠以高精度和可靠性到達工作空間中的任何一點,Agility 采用了一種隨機采樣方案,我們從工作空間中均勻地隨機選擇位置和方向,并在這些點之間生成隨機的平移和旋轉運動速度,為雙手和軀干創建時間索引軌跡。它使用一個考慮當前手部姿態和目標手部姿態之間平移和旋轉誤差的獎勵項來訓練其運動皮層,以到達這些點。

Agility Robotics 正在用全身控制器模型訓練 Digit。來源:Agility Robotics

位置 > 速度

為了訓練一個能夠以多種方式精確與世界交互的強化學習策略,Agility Robotics 表示希望機器人能夠走到世界中的特定位置并停留在那里。

然而,將強化學習應用于雙足機器人的大多數文獻都訓練神經網絡來跟蹤目標根速度(“匹配這個速度和方向”)而不是根位置(“到達這個點”),例如基于速度的 VMP、AMOR、FALCON、ExBody 和 ExBody2、HumanPlus、GMT、R2S2、MHC 與位置能力型 CLONE、OmniH2O 和 HOVER。

訓練控制器以跟蹤速度而不是位置,目的是為了移動,這提供了一個更豐富和更寬容的獎勵信號,因此通常是一個務實的選擇,Agility 表示。此外,在測試時在硬件上跟蹤根位置需要(非平凡地)某種形式的里程計,例如一個浮點基礎姿態估計器的實現。

然而,一個基于目標速度而非目標位置的移動控制器需要更高級別的規劃器對象或人類遠程操作員來提供持續的指導,以糾正位置漂移或考慮位置誤差。理想情況下,用戶會告訴控制器它應該在自由空間中的位置,它會導航到那里,即使被推搡或受到其他干擾,也會自然地返回到該位置。

在任務空間中進行提示比在配置空間中更好

另一個問題是,在先前的工作中,上肢目標設定點通常在關節空間中參數化。這意味著,要實際使用全身控制器,您需要要么配備動作捕捉服,并從人類配置空間映射到機器人配置空間,要么需要一個規劃器或模型來生成上肢運動計劃,Agility Robotics 表示。

它指出,這些是嚴重的限制,因為它們要求高級規劃層、人類遠程操作員或 LLM 需要擁有機器人運動學狀態模型。如果控制器基于的是自由空間位置和方向,那么對于下游腳本、 遠程操作和行為克隆等構建在控制器之上的應用來說,將更加方便。

這也有助于更接近用于最先進模仿學習方法所使用的表示方式,這意味著我們可以直接使用像 Gemini 這樣的模型來預測物體位置,以提供執行策略。

Agility Robotics 層疊行為

Agility Robotics 表示它正在積極建設和部署能夠在人類環境中執行有用工作的智能人形機器人。Digit 的“運動皮層”是其中的一部分,該公司表示。它作為一個“始終開啟”的安全層,能夠實現我們機器人的反應式和直觀控制。

“我們可以在這一層運動皮層之上構建復雜的行為,包括學習靈巧的移動操作行為,”它補充道。“我們認為這是朝著為現實世界的人形機器人構建一個安全可靠的運動基礎模型的第一步。”

想了解更多關于這個主題的信息,可以查看俄勒岡州立大學動態機器人與人工智能實驗室共同主任艾倫·費恩博士的文章:“ 正在興起的人形運動皮層:RL 訓練控制器的清單 。”

評論