OpenAI迎戰Deepseek

1月27日,DeepSeek應用登頂蘋果美國地區應用商店免費APP下載排行榜,在美區下載榜上超越了ChatGPT;同日,蘋果中國區應用商店免費榜顯示,DeepSeek成為中國區第一。而1月11日,DeepSeek的App才剛剛上線iOS和安卓的應用市場。

本文引用地址:http://www.czjhyjcfj.com/article/202502/466922.htm

DeepSeek橫空出世

DeepSeek,成立于2023年7月17日,全稱杭州深度求索人工智能基礎技術研究有限公司,專注于開發先進的大語言模型(LLM)和相關技術。在團隊配置上,相比OpenAI擁有1200名研究人員,DeepSeek團隊只有139名研發人員,其中算子、推理框架、多模態等研發工程師以及深度學習方面的研究人員共有約70人。

2023年5月,DeepSeek創始人梁文鋒開始進入通用人工智能(AGI)領域,從公開的工作經歷和職業生涯來看,他的創業范疇橫跨金融和人工智能領域,在量化投資和高性能計算領域具有深厚的背景和豐富的經驗。2015年,30歲的梁文鋒和朋友一起創辦了杭州幻方科技有限公司,立志成為世界頂級的量化對沖基金;2016年10月,幻方量化(High-Flyer)推出第一個AI模型,第一份由深度學習生成的交易倉位上線執行;到2017年底,幾乎所有的量化策略都采用AI模型計算;2019年,幻方量化成為國內首個募資超過1000億元的的量化對沖基金。

在AI科技領域,美國長期以來都是創新的引領者,一直以來都被認為是追趕者的中國公司,第一次在AI行業中站上世界舞臺的中心。而且,DeepSeek的核心研究員都是中國本土培養的博士,沒有海外留學的背景,在一定程度上打破了技術創新只能在美國出現的刻板印象。

DeepSeek的全球熱議還帶來了美股的驚天震動,英偉達單日大跌近17%,市值蒸發近6000億美元(相當于人民幣4.3萬億),創美股單日跌幅最高紀錄。原因不僅是因為DeepSeek訓練成本下降,帶來了芯片算力需求可能會下降的恐慌,也源自傳統的美國科技資本邏輯受到的沖擊。

出道即巔峰

DeepSeek可以說是“出道即巔峰”,2024年12月26日宣布旗下全新系列模型DeepSeek-V3首個版本上線并同步開源,總參數達6710億,采用創新的MoE架構和FP8混合精度訓練,并公布了長達53頁的訓練和技術細節。真正讓DeepSeek火出圈的是 —— 其總訓練成本只有557.6萬美元,而GPT-4o的約為1億美元,使用25000個GPU芯片。

在DeepSeek發表的原始報告中有詳細解釋這筆成本的計算:在預訓練階段,每兆個token上訓練DeepSeek-V3僅需要180K H800 GPU小時,也就是說在擁有2048個H800 GPU的叢集上需要3.7天。因此,預訓練階段在不到兩個月的時間內完成,耗費2664K GPU小時。加上上下文長度擴充所需的119K GPU小時和后制訓練所需的5K GPU小時,DeepSeek-V3的完整訓練僅需2.788M GPU小時。假設H800 GPU的租賃價格為每GPU小時2美元,總訓練成本僅為557.6萬美元。

DeepSeek-V3通過數據與算法層面的優化,大幅提升算力利用效率,實現了協同效應。這證明,模型效果不僅依賴于算力投入,即使在硬件資源有限的情況下,依托數據與算法層面的優化創新,仍然可以高效利用算力,實現較好的模型效果。

· DeepSeekMoE(Mixture of Experts,混合專家)

傳統稠密模型,比如GPT-3.5,在訓練和推理過程中激活全部參數。然而事實上,并非模型的每個部分都是當前任務所必需的。因此,MoE的理念是將模型區分為多個「專家」,推理時只激活對任務必要的專家。MoE模型的效率優勢正源于其選擇性激活機制,與傳統模型(如Llama)需要激活全部網絡權重不同,MoE通過對計算網絡進行分類,顯著降低計算成本。

MoE模型此前未被廣泛應用的主要障礙是訓練難度大,容易出現信息分類不當,DeepSeek V3通過創新性的算法和工程優化,成功突破這一限制。DeepSeek在V3模型論文中稱,相較于傳統MoE,DeepSeekMoE使用了“更細粒度”的專家,使專家更加專門化,單個專家僅數十億參數,提升了任務適配性;同時,DeepSeekMoE將一些專家隔離為“共享專家”,用于減輕專家之間的知識冗余,從而使V3模型在激活相同數量專家和參數的情況下表現更好。

· MTP(Multi-Token Prediction,多tokens預測)

傳統大模型回答用戶需求時只預測下一個token,V3通過MTP技術同時預測下2個token。這里的關鍵是第二個預測token的準確性問題(即「接受率」,預測的token能被最終采用的比例)。DeepSeek評估稱,在不同生成主題中,其模型所生成的第二個token的接受率達到了85%至90%。這種高接受率意味著V3能夠以接近傳統單token預測模式兩倍的速度來生成文本。

· FP8:低精度訓練

FP8的意思是8位浮點(floating-point),數字越高,意味著計算精度越高,但與此同時計算速度會降低。DeepSeek使用了FP8數據格式來訓練V3,并在模型計算的不同環節實現了數據在FP8、BF16、FP32等不同精度下的靈活和交替使用,即一種混合精度框架。在參數通信的部分過程,DeepSeek也做到了FP8精度的傳輸。通過這一過程,DeepSeek實現了加速訓練和減少GPU內存使用,并「首次在超大規模模型上驗證了FP8混合精度訓練框架的有效性」。

DeepSeek V3的大量創新都與為克服使用H800而不是H100所帶來的內存帶寬不足有關。為此,DeepSeek甚至繞過了英偉達的編程工具CUDA,對每塊H800芯片上132個處理單元中的20個進行了重新編程,以專門用于管理跨芯片通信。DeepSeek以1/11的算力、僅2000個GPU芯片訓練出性能超越GPT-4o的大模型,雙方的成本至少是10倍的差距。「性價比」是商業社會中的制勝法寶之一,憑借其驚人的性能表現和低成本訓練模式,DeepSeek迅速吸引了全球關注,且熱度一直不減。

算力不再是“緊箍咒”?

DeepSeek的出現打破了英偉達等科技巨頭的算力路徑,走出了另一條路也就是說,提高AI模型能力不再需要那么高昂的門檻了,即不一定要提升很高的參數規模就能實現很高的性能,可能對算力需求至少降到10倍以上。在數據方面,與OpenAI“海量數據投喂”的方式不同,DeepSeek利用算法把數據進行總結和分類,經過選擇性處理之后,輸送給大模型,提高了訓練效率也降低了的成本。

DeepSeek-V3極低的訓練成本預示著AI大模型對算力投入的需求將大幅下降,但由經濟學家威廉·斯坦利·杰文斯提出的杰文斯悖論:當某種資源的使用效率提高、獲取變得更容易時,其總體使用量往往不減反增。DeepSeek的發展也呈現出類似的趨勢:算力效率的提升并未減少對算力的需求,反而推動了更多高算力應用的落地,使得行業對算力的需求持續增長。不過短期內,向英偉達大手筆下單的技術公司會變得更謹慎。

與ChatGPT等其他聊天機器人的不同之處在于,DeepSeek的同名聊天機器人在回應用戶提問時,會將思維鏈條(Chain of Thought,CoT)完全展示出來,其作為機器人認真揣摩用戶需求、試圖將用戶所有說出口或隱晦表達的情緒都安慰到位的“內心活動”激發了大量用戶的熱情。商業的本質在于創造稀缺,無論在人類成員還是AI成員中,共情能力都是稀缺品。

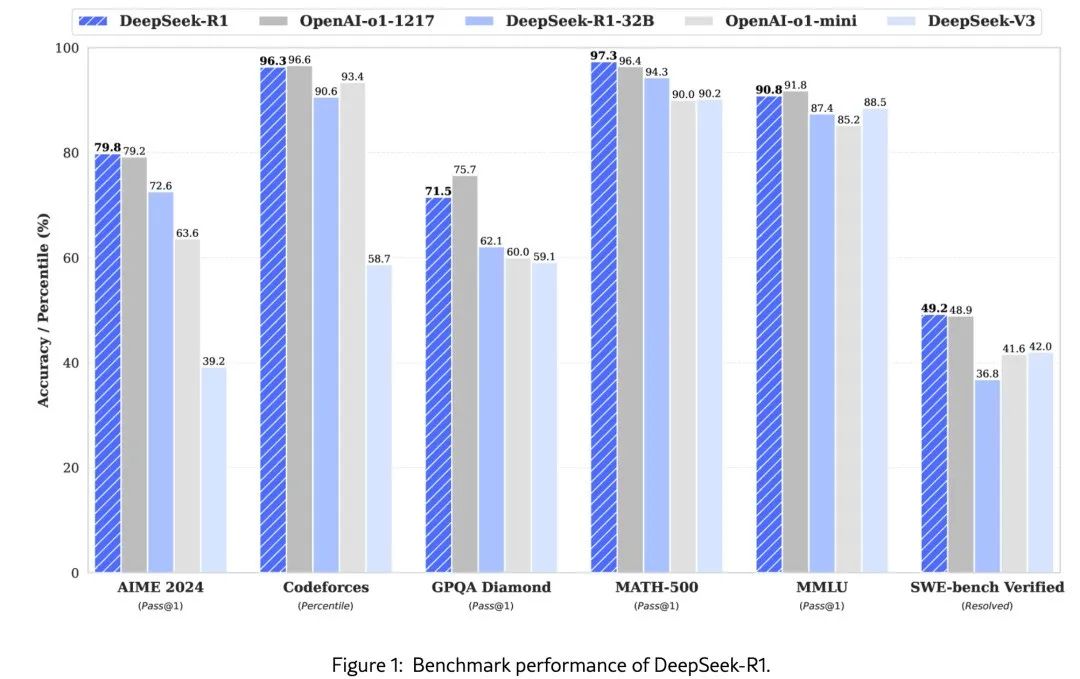

?2025年1月20日?:發布新一代推理模型DeepSeek-R1,在各項性能與OpenAI的GPT-4o持平,并開源?。V3模型和R1系列模型都是基于V3模型的更基礎版本V3-Base開發的,相較于V3(類4o)模型,R1(類o1)系列模型進行了更多自我評估、自我獎勵式的強化學習作為后訓練。在R1之前,業界大模型普遍依賴于RLHF(基于人類反饋的強化學習),但R1系列模型放棄了RLHF中的HF(human feedback,人類反饋)部分,只留下純粹的RL(強化學習)。

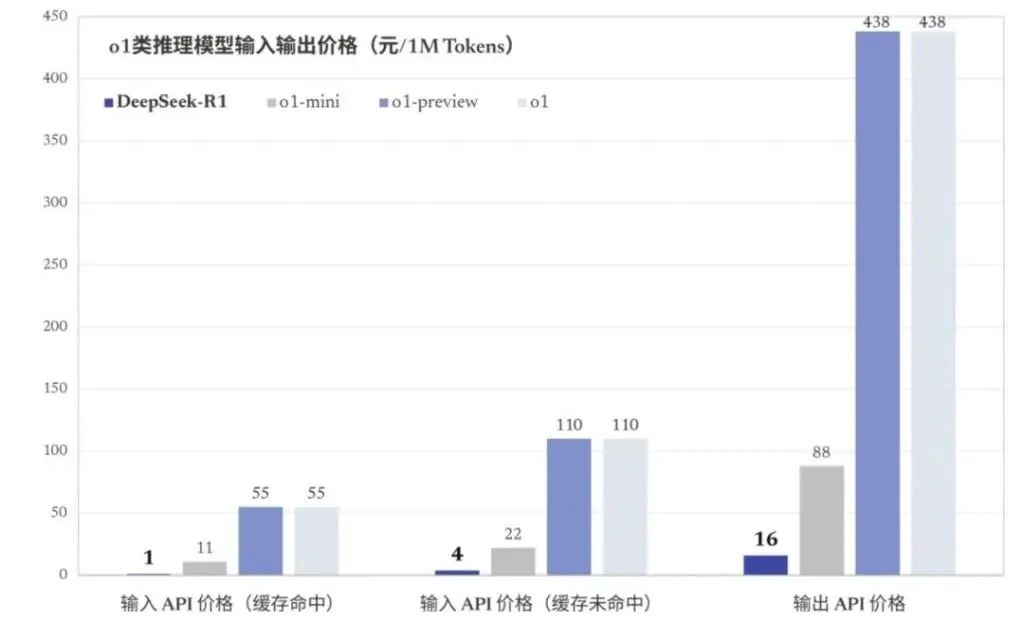

推理成本上,OpenAI o1每百萬輸入和百萬輸出token分別收取15美元和60美元,而DeepSeek R1同樣輸入與輸出的價格分別只要0.55美元和2.19美元,差不多只是前者的3%。

國外獨立評測機構Artificial Analysis測試了DeepSeek-V3后得出的結論:DeepSeek-V3超越了迄今為止所有開源模型。需要注意的是,對比Android與iOS的生態隔離,開源與閉源大模型均基于Transformer架構,差異是在數據、算法運用、工程等維度,并非是截然不同的技術路線。

由于DeepSeek這次的開源,讓行業最領先的水平平權了,會加速推動AI進化的速度,進而推動必要條件的成熟,帶來新的應用機會。我們在討論DeepSeek開源的時候,都指的是LLM大語言模型,但是除了語言模型,AI還有非常重要并行的領域是多模態模型。DeepSeek在近期也發布了圖像模型Janus pro,然而效果一般,在多模態的領域,開源還有更長的路要走。

DeepSeek的崛起標志著全球人工智能競賽的“轉折點”,證明中國可以利用更少的資源與大科技公司競爭。DeepSeek發布的較低成本的開源AI模型爆火,這也讓OpenAI重新思考,需要“弄清楚另一種開源戰略”。外媒表示,盡管不太可能很快看到OpenAI開源其任何模型,但DeepSeek的沖擊肯定會讓OpenAI有所改變。

OpenAI迎戰Deepseek

目前,OpenAI的ChatGPT已坐擁超3億月活躍用戶和超1100萬付費用戶,收入主要來自ChatGPT付費訂閱收入和API接口服務收入。其中,ChatGPT Plus每月收費20美元,ChatGPT Pro每月收費高達200美元,ChatGPT Plus和ChatGPT Pro主要面向個人用戶,是OpenAI收入中最大的部分。2024年12月中,OpenAI首席財務官曾透露,OpenAI計劃推出一款月訂閱費高達2000美元的人工智能產品,稱之為AI Agent(AI代理),并將2025年的營收目標從80億美元上調到120億美元。

OpenAI在市場上占得了先機,有著全球領先的AI大模型如GPT-4o、o1,可以借助自家閉源AI模型在技術上領先的優勢繼續發展更多的付費用戶。而DeepSeek在AI領域突然半路殺出,可能就會對ChatGPT的付費商業模式帶來強烈的沖擊。

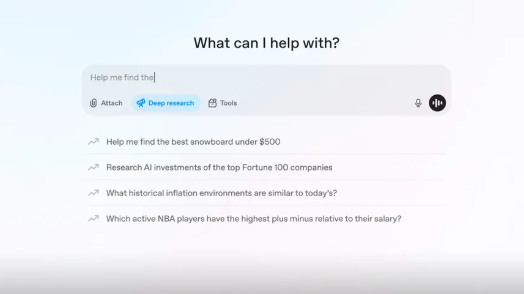

面對DeepSeek的強勢挑戰,OpenAI帶來了全新產品 —— Deep Research,是一個使用推理來綜合大量在線信息并為用戶完成多步驟研究任務的智能體,旨在幫助用戶進行深入、復雜的信息查詢與分析,最終形成一份專業水準的綜合報告。為實現這一點,OpenAI針對需要使用瀏覽器和Python工具的現實任務進行訓練,采用的強化學習方法與其首個推理模型o1相同。

這樣的能力使得原本需要人類數小時才能完成的研究任務,縮短至三十分鐘左右,目前Pro用戶現已可用。使用Deep Research非常簡單,只需在ChatGPT界面選擇“Deep Research”模式,輸入研究需求,甚至可以上傳參考資料。整個研究過程會實時顯示在側邊欄,研究完成后用戶會收到通知。

盡管Deep Research展現出強大的功能,但OpenAI也承認其仍存在一些局限性,如信息準確性和報告格式的瑕疵。隨著使用量的增加,OpenAI計劃不斷優化模型,力求解決這些問題。未來的更新中,Deep Research還將支持更多圖表和可視化內容的展示,以進一步提升清晰度并提供更多背景信息。OpenAI首席執行官Sam Altman曾表示在人工智能領域,“最重要的進步領域將圍繞推理能力展開”,在OpenAI看來,Deep Research功能朝著其開發AGI的宏大目標邁出了重要一步。

雖然英偉達的A100、H100等性能出色,但價格高昂,加之龐大的需求,芯片也就成為了一項巨大的支出,這也促使廠商自研芯片降低成本,減少對英偉達的依賴。最新消息顯示,OpenAI正積極推進完成自家首款自研人工智能芯片,并將采用臺積電3nm制程工藝,計劃2026年實現大規模生產。

目前,OpenAI的內部設計芯片團隊有40人,由谷歌的前工程師Richard Ho帶領。此外,OpenAI在設計芯片上或將與博通合作。這不僅是對芯片設計的一次實戰檢驗,更是OpenAI向大規模自主芯片生產邁出的關鍵一步。OpenAI自研的芯片,初期在AI模型的運行中將扮演有限的角色,但同樣也具備用于訓練AI模型的能力,未來可能用于大模型的訓練,如果進展順利也計劃研發性能更強的芯片。

評論